Parte de la sociedad considera los modelos de inteligencia artificial (AI) y aprendizaje automático (ML) como herramientas objetivas y analíticas, aunque estas no garantizan ser equitativas a la hora de tomar decisiones.

Al final, las personas somos propensas a los errores. Vivimos llenas de ideas preconcebidas y de tendencias invisibles producto de ser quienes somos, venir de dónde venimos y el modelado de las circunstancias.

Un grupo reducido de esos seres imperfectos, ha creado unas criaturas abstractas llamadas algoritmos como solución a problemas de todo tipo.

Como los sistemas operan en función de quién los construye, qué datos se toman en cuenta y cómo se miden, se produce lo que se conoce como sesgo algorítmico. Este término describe los errores sistemáticos y repetidos que crean resultados injustos.

Aparentemente, quienes programan, responsables del desarrollo de estos algoritmos, alimentan las rutinas con miles o millones de datos, imágenes o vídeos.

El algoritmo, a partir de estos ejemplos, que son un fiel reflejo de la sociedad en la que vivimos o hemos vivido, infiere el modelo que debe aplicar a cualquier situación posterior.

Si durante la fase de entrenamiento/aprendizaje no se seleccionan cuidadosamente los ejemplos, es posible introducir sesgos en el modelo.

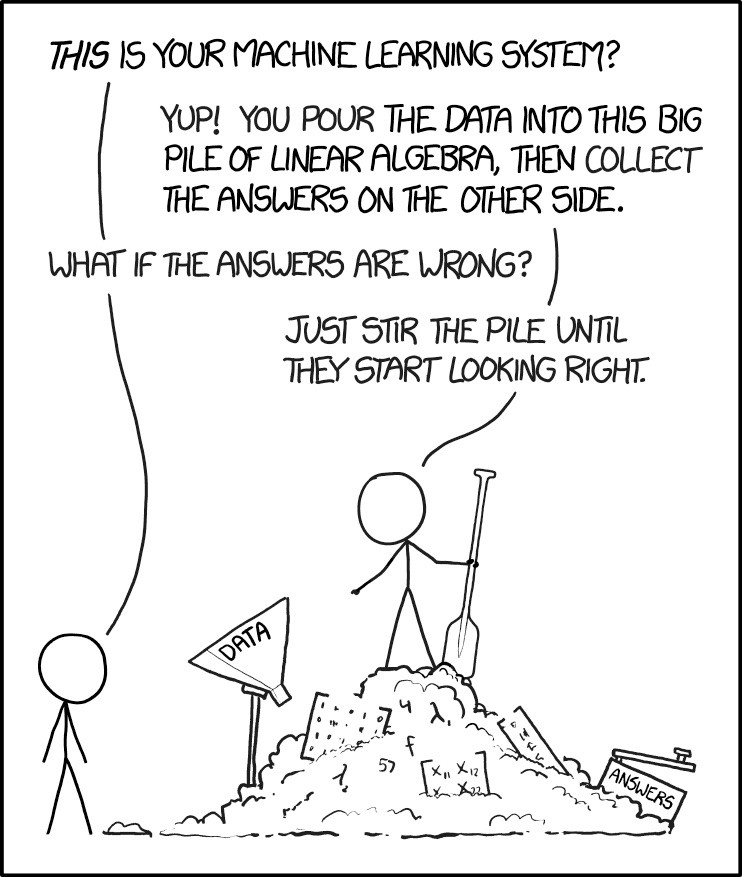

Si todos los vídeos o la mayoría de vídeos muestran personas de raza blanca, el algoritmo podría tener problemas para identificar correctamente a una persona de raza negra.

Como consecuencia, los modelos de machine learning producen resultados en base a los datos que se usen para entrenarlos, tanto en calidad y sesgos.

“Los algoritmos discriminatorios tienen la capacidad de hacernos retroceder décadas en paridad de género”

Susan Leavy, investigadora de la University College Dublin.

Existen innumerables ejemplos para mostrar el concepto de sesgo algorítmico, pero en este post nos centraremos en los siguientes:

Impartición de justicia

Cada vez más, los algoritmos han empezado a arbitrar la justicia. En consecuencia, a las personas que crean estos algoritmos se les pide que expresen en su código lo que significa ser justo, y, por ello, la sociedad debe tener que lidiar con la siguiente pregunta: ¿Cómo se puede cuantificar matemáticamente la justicia?

El algoritmo al que hacemos referencia se conoce como COMPAS y es una de las varias herramientas de evaluación de riesgo que se usan en EE. UU. Este proceso es muy imperfecto, dado que se utilizan los arrestos previos como un indicador de los delitos, pero la policía tiene un historial desproporcionado de arrestos de minorías raciales y de manipulación de datos.

Sus defensores argumentan que ayudan a que el sistema de justicia penal sea más justo sustituyendo la intuición y el sesgo de los jueces (el sesgo racial); pero, de acuerdo con la ley, COMPAS no incluye la raza en el cálculo de su puntuación de riesgo y, aun así, en 2016, una investigación reveló que la herramienta estaba sesgada contra los negros. ProPublica descubrió que, entre los acusados, los negros tenían el doble de probabilidades que los blancos de acabar en el grupo de alto riesgo de COMPAS.

Discriminación por genero

Dos siglos más tarde de los primeros algoritmos, éstos, “tienen la capacidad de hacernos retroceder décadas en paridad de género“, según Susan Leavy, investigadora de la University College Dublin.

“Pueden exacerbar la masculinidad tóxica y las actitudes que hemos estado combatiendo durante décadas en la sociedad“, añade.

No es culpa de los algoritmos, sino de la historia de la humanidad.

La Inteligencia Artificial (IA) aprende de datos que están sesgados, incluso aquellos que describen el mundo, debido a la discriminación histórica de las mujeres, reproduciendo los prejuicios de entonces y no incorporando los avances sociales recientemente conquistados.

“Continuamos repitiendo los errores del pasado“, señala la investigadora. Esta brecha de género en datos se conoce como gender data gap.

Eso explica que Facebook haya publicado anuncios de trabajo bien pagados para hombres blancos, mientras que a las mujeres y a las personas de color se les proponía empleos de peor calidad. Amazon también tuvo que eliminar su algoritmo de selección de personal porque mostraba un fuerte sesgo de género, penalizando los currículos que contenían la palabra mujer. Hasta Rosalía se ha hecho eco de este asunto en Spotify.

Discriminación por raza

Facebook ha tenido que pedir disculpas públicamente por el comportamiento racista de sus herramientas de inteligencia artificial. No hace mucho tuvo que desactivar una de sus rutinas de etiquetado automático y recomendación de vídeos, tras detectar que había asociado a varios hombres negros con la etiqueta “primates” y sugería a los usuarios ver más vídeos de primates a continuación. O hace menos de un mes, al clasificar intencionadamente a los usuarios en base a datos protegidos.

Por todo lo anterior, se puede concluir que la discriminación algorítmica no es algo nuevo, pero si la preocupación por darle respuesta.

Lo cierto es que discriminación y algoritmos han convivido desde el inicio porque todo algoritmo, por básico que sea, incluye sesgos y estos discriminan.

Así pues, es de vital importancia reconocer y tener en consideración que estos algoritmos inteligentes pueden perpetuar el “statu quo”, reproduciendo las mismas discriminaciones históricas o incluso acentuándolas.

En definitiva, es necesaria una regulación algorítmica como esperanza para el futuro.

La lucha por corregir el pecado original de la inteligencia artificial se desarrolla a un ritmo menor que la implantación de su tecnología, lo que puede provocar desconfianza en la sociedad.

La solución pasa por formar equipos multidisciplinares expongan a las máquinas a todo tipo de pruebas que puedan afinar las predicciones. Un proceso de prueba y error evidente en cualquier investigación científica, pero que en el caso de los algoritmos no se ha tenido paciencia para aplicarlo.

Está en nuestra mano no repetir los peores patrones de la sociedad.

Puedes leer más sobre el tema en: